Il mio stack ELK —

Visto il momento attuale in cui la cyber criminalità la sta facendo da padrona, oltre al “pararsi le terga” in ogni modo possibile ed immaginabile una grossa fetta di lavoro è anche spazzolarsi i log di sistema macchina per macchina per vedere se c’è un qualcosa che non convince, ed è un lavoraccio immane.

Guardando questo video sul canale youtube di Sistemista Italiano che è una vera miniera di idee, soluzioni, trucchi vari & assortiti per facilitarsi la vita, mi è venuta l’idea/voglia di fare una cosa del tipo.

Faccio una breve premessa, sia il video che i vari howto che si trovano in rete raccomandano di usare un web server come reverse proxy e di usare TLS.

È giusto e sacrosanto come forma mentis, se dovessi monitorare i log di una macchina al di fuori della mia LAN non ci penserei nemmeno e farei alla stessa maniera, qui al nostro interno non mi sembra il caso di complicarsi(mi) la vita inutilmente, è uno strumento che userò solo io e di cui gli altri non saranno a conoscenza, dall’esterno è molto difficile entrare anche per uno molto bravo, infatti l’unico modo per entrare è avere una VPN valida o avere la chiave ssh su uno dei nodi perimetrali.

Quindi ho optato coscientemente per una soluzione che passa il traffico in chiaro, per altro nel momento in cui mi rendessi conto di avere questa necessità non sarebbe un lavoro eccessivamente complesso aggiungerla.

Lo stack ELK acronimo per Elasticsearch Logstash Kibana è uno stack composto da tre prodotti open source gestiti da Elastic

Elasticsearch è un database NoSQL

Logstash è uno strumento di pipeline di log che accetta input da varie fonti

Kibana è una dashboard di visualizzazione che funziona su Elasticsearch

Lo stack comprende anche Beats che e’ un log shipper o log forwarder che completa la suite.

La nota a mio avviso dolente di tutto questo è che per funzionare si appoggia a java, e io sono notoriamente abbastanza allergico a java, ma è un mio problema.

La distribuzione su cui ho lavorato è una Devuan 3.1 attuale stable, i passi per abilitare i repository di elastic sulla macchina che farà da server e su quelle che saranno i client (le macchine perimetrali) sono i seguenti:

wget -qO – https://artifacts.elastic.co/GPG-KEY-elasticsearch | apt-key add –

echo “deb https://artifacts.elastic.co/packages/oss-7.x/apt stable main” | tee -a /etc/apt/sources.list.d/elastic-7.x.list

apt-get update

Una volta finito di configurare e aver lanciato i demoni con un browser puntare ad ardito:5601

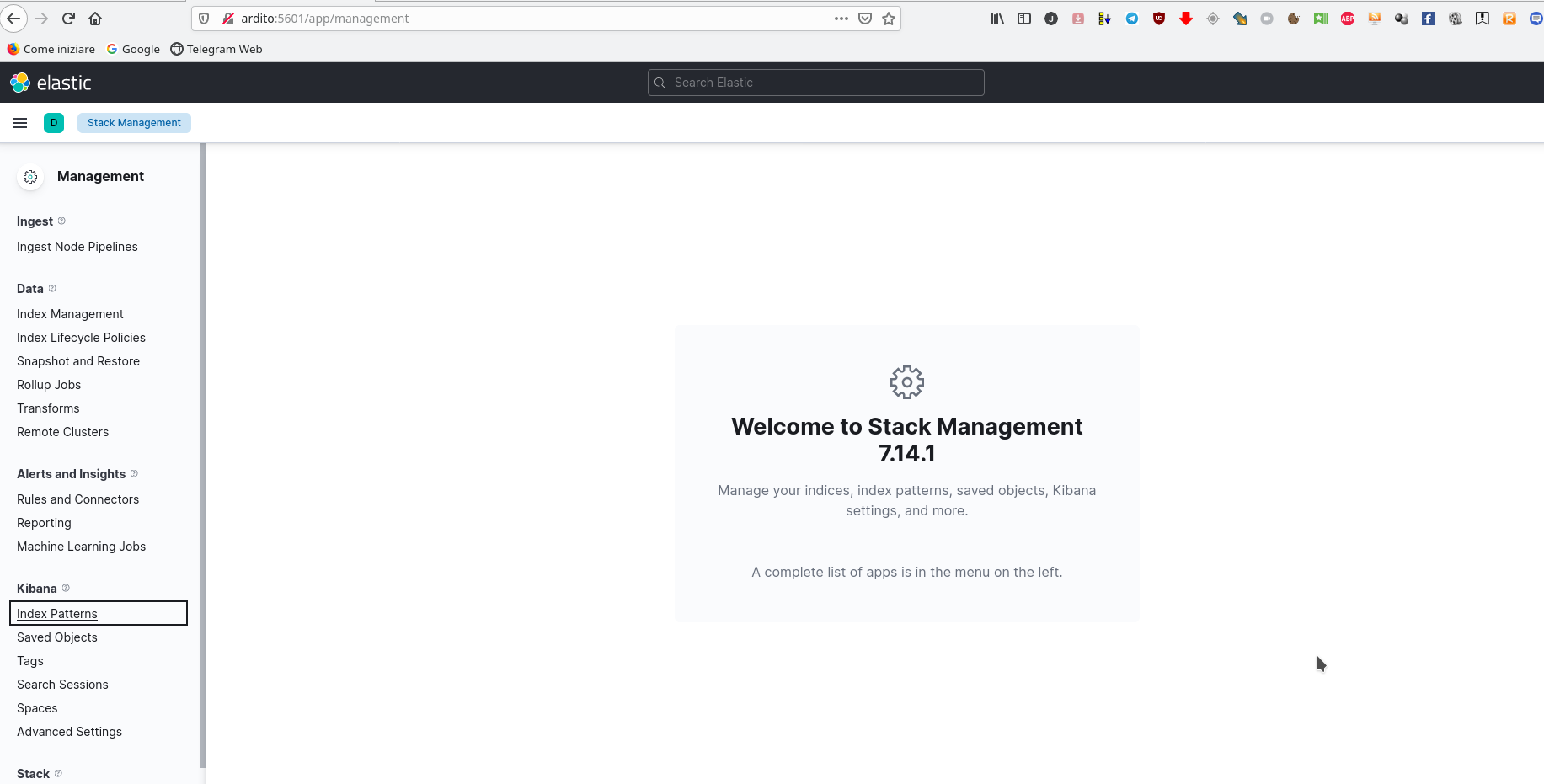

e cliccando su Manage si aprirà quest’altra schermata

dove a sinistra cliccheremo su index pattern sotto il menù kibana e avremo questa schermata

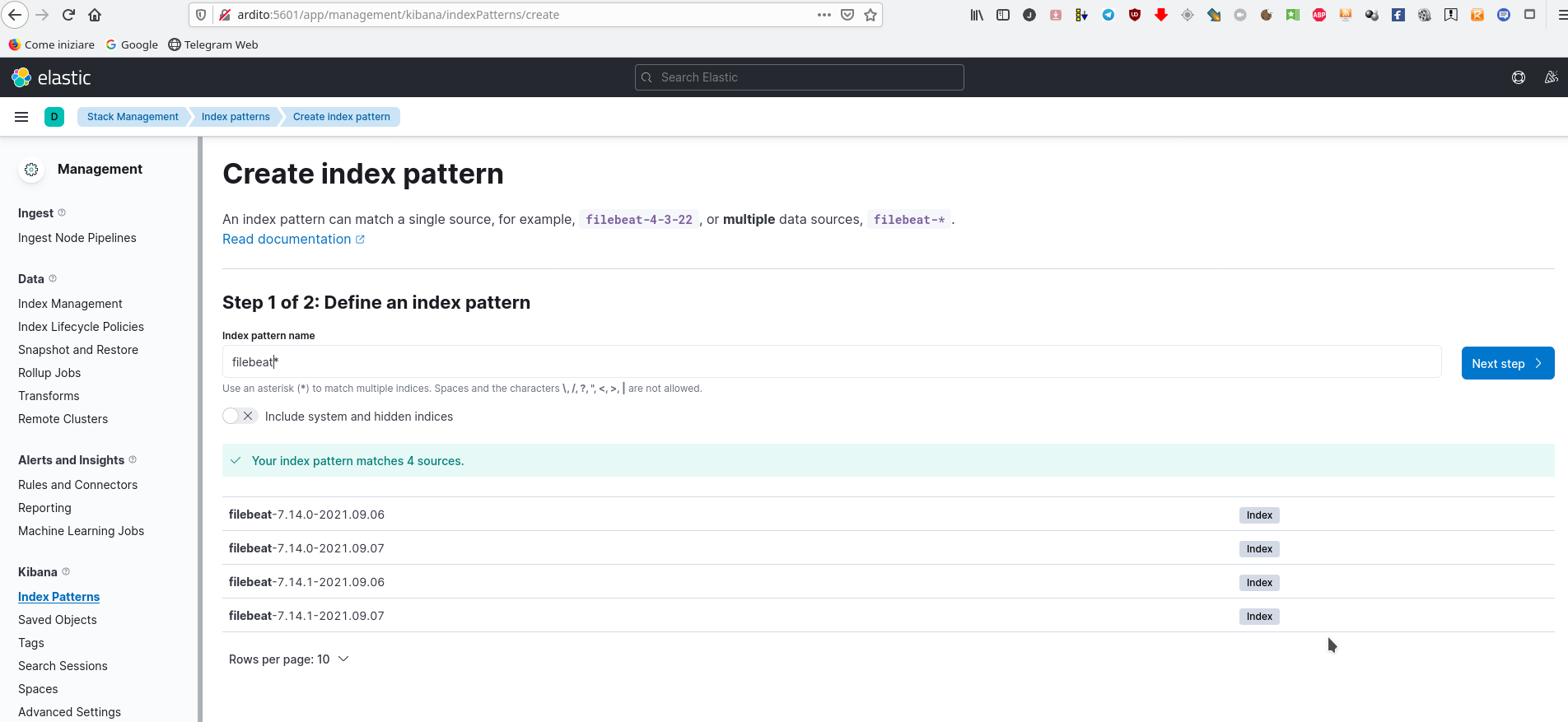

cliccando su create index pattern avremo

nella riga create index pattern inseriremo filebeat* e quindi next step

dove nel menù a tendina a sinistra andremo a scegliere @timestamp e quindi a destra create index pattern che fornirà

dove si possono trovare tutti i campi che sono stati creati, cliccando in alto a sinistra su elastic si torna alal schermata principale da cui siam partiti e cliccando di nuovo su kibana avremo

dove cliccando su Discover avremo

che ci indica che i nostri nodi stanno effettivamente spedendo informazioni al server, cliccando sulla freccina a sinistra di ogni record si apre una pagina con una marea di informazioni a riguardo.

Categorised as: firewall | IDS | Linux | Networking | Web application | Work

Comments are disabled on this post